Cuando en Julio decidimos de forma interna que molaría mucho regalar a los Tarug@s un NFT de una imagen generada por IA (algo digital que nos representase como empresa) no teníamos ni idea de la locura en la que nos estábamos metiendo: ¿Seríamos capaces de entrenar una IA que dibujase con el estilo de Hugo Tobio (dibujolari de la Bonilista)?, ¿los modelos de IA generativa podrían replicar el estilo de Hugo?

Lo primero que hicimos fue contactar con Hugo y con David, que se subieron al barco sin pensarlo y sin saber si llegaríamos a buen puerto (o qué resultados obtendríamos).

Para calentar motores, Hugo nos pasó una serie de 300 ilustraciones con las que empezamos a probar diferentes herramientas y modelos permitían el entrenamiento con imágenes (MidJourney, Dall e 2, IMAGEN, nuestras propios modelos de ML…).

En Agosto (que hoy día nos parece el pleistoceno de la IA generativa), los resultados que obteníamos no eran lo que buscábamos. En algunos casos porque para generar imágenes necesitábamos de prompts larguísimos donde ir ajustando el modelo y el “discurso” para encontrar un estilo parecido al de Hugo, en otros, porque el aprendizaje se realizaba partiendo de la “imitación” de una imagen.

Cuando estábamos enfrascados en una línea de trabajo que creíamos prometedora (pero costosísima en tiempo), los chicos de StabilityAI anunciaron que liberaban Stable Diffussion, un trabajo realizado junto con CoreWeave y HugginFace. Todos ellos con raíces comunes en la Univerdad de Munich.

El anunció supuso una disrupción inmediata por varios motivos: se liberaba bajo licencia Creative ML OpenRAIL-M, lo que en la práctica supone poner a disposición un modelo que se puede utilizar como base para otros. Además, habían conseguido entrenar un modelo que pesaba muy poco, textualmente “is the culmination of many hours of collective effort to create a single file that compresses the visual information of humanity into a few gigabytes” .

Por si fuera poco, dejaron en manos de la comunidad cómo solucionar los problemas éticos de haber entrenado un modelo con un set de imágenes recogidos por Internet, ya que estos podrían reproducir prejuicios sociales y producir contenidos inseguros. En la release crearon un “safety-classificator” que permitía mitigarlos en parte, pero lo liberaron con la posibilidad de desactivarlo o generar uno propio.

Anteriormente, otros players como OpenAI tuvieron dudas a la hora de liberar sus modelos, entre otras cosas precisamente por esto, porque consideraban que podía ser una herramienta insegura y con sesgos si no se trabajaba adecuadamente.

La comunidad acogió Stable Difussion con gran entusiasmo y enseguida empezaron a aparecer modelos, versiones, interfaces web… E integraciones con otras herramientas ya consolidadas en el mercado: Plug-ins para Photoshop, librerías que se integran con Unity, integraciones con Blender, etc.

¿Qué nos ha funcionado y qué no?

Una vez metidos en “harina” en el entrenamiento con Stable Difussión hubo cosas que funcionaron y otras que no.

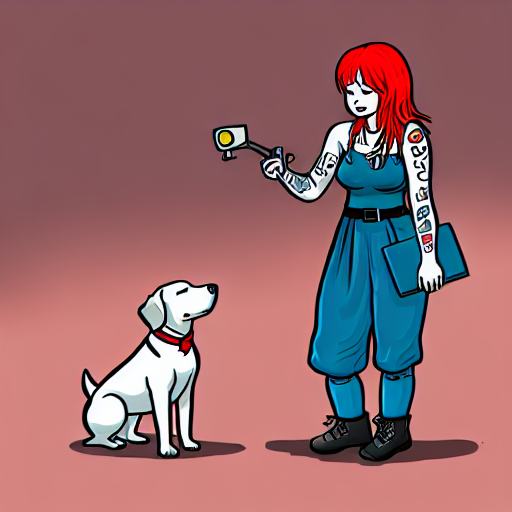

El estilo de las imágenes de Hugo es muy marcado y reconocible, pero la temática y su creatividad variadísima. Cuando más grande era el dataset del modelo, peor funcionaba. Hicimos un trabajo previo de clasificación por temáticas y nos quedamos con un set de pocas imágenes que en su mayoría representaban personas, otro set donde aparecían animales… Y así entrenamos diferentes modelos.

Stable Diffusion funciona estupendamente para generar imágenes realistas y artísticas con estilos y referencias muy reconocibles, incluso con aquellos artistas que tienen una buena base de imágenes en Artstation, por ejemplo. Pero todo lo que tiene que ver con ilustración digital basada en un formato similar a comic/viñeta/etc. no está tan logrado.

Quizás el salto cualitativo fue utilizar DreamBooth junto a StableDifussión, que supuso un nuevo enfoque para la personalización de los modelos de generación de imágenes especializándolos según las necesidades del usuario.

El 25 de agosto de 2022 un equipo de 6 investigadores de Google Research publican un paper titulado DreamBooth: Fine Tuning Text-to-Image Diffusion Models for Subject-Driven Generation donde presentaban al mundo a DreamBooth con esta frase: “Es como una cabina de fotos, pero una vez que se captura el sujeto, se puede sintetizar donde sea que te lleven tus sueños…”.

A finales de septiembre de 2022, Xavier Xiao sube a su Github un nuevo concepto: utilizar Stable Diffusion como base para DreamBooth y dejar el código necesario. En este espacio, Xavier afirma que en la implementación original de DreamBooth se basa en el modelo Imagen de Google, sin embargo, un usuario común no tiene acceso a ese modelo ni a los pesos preentrenados del mismo. Por tanto, su idea fue sustituir Imagen por Stable Diffusion y permitir que cualquier persona pudiera personalizar su modelo.

Por último, para la generación masiva de prompts e imágenes hemos generado el modelo en formato ckpt utilizado Automatic1111.

Los resultados

Verás que en general, hemos optado por temáticas cercanas a nuestros gustos: ciencia ficción, referencias a películas, personajes famosos, comics, etc.

Estas temáticas están alejadas de las ilustraciones de la Bonilista y aunque ciertos elementos del estilo los ha captado la AI, no terminan de ser Hugo.

Una de las grandes dificultades a lo hora de generar una imagen es tener un prompt adecuado, algo que refleje la sutileza e ironía que por ejemplo Hugo pone cada una de sus ilustraciones y que Stable Difussión no ha utilizado para entrenar su modelo. Intentar reproducir esto un prompt y que la IA entienda la ironía y sutileza, de momento es directamente imposible.

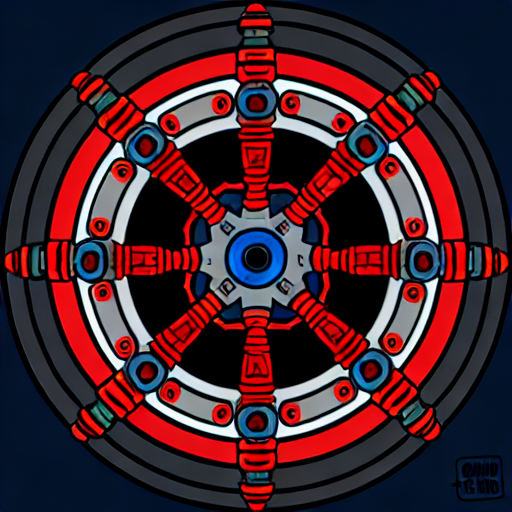

Otro de los problemas que nos hemos encontrado es que hay ciertos elementos de ciertas imágenes que pesan mucho en el entrenamiento y no siempre tienes la clave para cambiarlas.

Por ejemplo, es curioso cómo la máquina replica uno de los elementos que contenía una de las imágenes que utilizamos para el entrenamiento (todo objeto circular era “timonizado”). La cantidad de timones objetos tecnológicos flotando que aparecían fue bastante alta.

En definitiva, es flipante la comunidad que se ha creado con el mix Stable Diffusion + DreamBoth -(que apenas tienen 50 días de vida) y la cantidad de campos que ya ha abierto, pero es aun más flipante la cantidad de novedades diarias y velocidad de la comunidad en aplicar esto a cualquier campo:

Es seguro que dentro del campo de la ilustración y diseño gráfico se creará un nuevo tipo de profesional que esté especializado en AI Art y conceptualización con estas herramientas, aunque de momento todavía está lejos de poder reemplazar a un artista. La sutileza, la ironía, el humor, el tono, la improvisación, en definitiva, la creatividad propia de una obra de arte no es tan fácil de replicar.

Pero retomando el tema… ¿Por qué hacer un NFT?, ¿qué se puede hacer con él?

Hemos querido hacer un pequeño guiño a la tecnología blockchain y el concepto de NFT. Much@s artistas tienen dudas sobre el uso y beneficios de los NFTs, en gran parte debido al hype que hubo con su utilización masiva, ya que como todo buen hype, dio lugar a mucha especulación, fraude y scammers.

Pero si dejamos esto a un lado y nos vamos a su esencia al final, en este caso un NFT representa un asset digital que alguien crea y “registra” en una blockchain pública para dar fe de su existencia, inmutabilidad, pertenencia… En definitiva, lo que queremos es regalaros las imágenes creadas por esta IA en vez de imprimir un poster (que pa’ eso somos Tarug@s apasionados por la tecnología).

La intención es que esto sirva para conocer un poco el ecosistema de aplicaciones y utilidades que aparecen alrededor de una blockchain y la enormidad de cosas interesantes que se pueden realizar con ellas.

Además, podrás cambiarlo con otros Tarugos a través de MyAlgo Wallet, subastarlo en sitios como AlgoxNFT o simplemente conservarlo como un bonito recuerdo digital de un eventazo como es la TarugoConf.

¿Y por qué en Algorand?

Hemos elegido Algorand por varios motivos, aunque el principal ha sido porque se han preocupado muy-mucho por conseguir ser Carbon Free minimizando el impacto enérgico gracias a algoritmos de consenso mucho más eficientes, etc. Además, los fees por cualquier tipo de transacción son ínfimos: 0,001 algos (0.00031$), que eso también está muy bien.

Sin duda, cosas que tuvimos muy en cuenta a la hora de trabajar en otros proyectos, como el desarrollo de una criptomoneda basada en Algorand.

Extra content: links molones que no puedes perderte

- Entrena tu propio modelo con el manual que encontrarás pinchando aquí.

- Entiende el ecosistema NFT de Algorand.

- Aprende a generar prompts o encuentra ideas.